はじめに

製造業の業務で機械学習モデルを運用する際に重要になる説明性・解釈性を把握するための手法を学ぶために,森下光之助 著 「機械学習を解釈する技術〜予測力と説明力を両立する実践テクニック」を読むことにした。

本記事は,「第2章 線形回帰モデルを通して「解釈性」を理解する」の読書メモである。

- 本書の紹介ページ

機械学習を解釈する技術 〜予測力と説明力を両立する実践テクニック:書籍案内|技術評論社

- 関連コード

GitHub - ghmagazine/ml_interpret_book

本記事を読むことで得られること

本記事を読むことで得られることは,主に以下の内容である。

- 線形回帰モデルを例にした,4つの解釈性のイメージとその意味

第2章 線形回帰モデルを通して「解釈性」を理解する

本章では,線形回帰モデルを例に挙げて,本書のテーマである「機械学習の解釈性」に関する概観を説明している。

2.2 線形回帰モデルが備える解釈性

本節では,線形回帰モデルが持つの4つの解釈性について説明している。この4つの解釈性とは,以下の通りである。

特徴量と予測値の平均的な関係

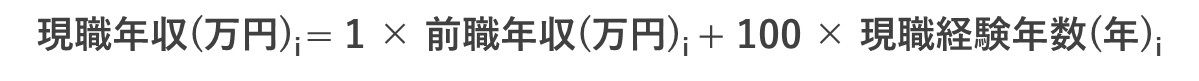

線形回帰モデルは例えば,

のように表される。この線形回帰モデルでは,特徴量がそれぞれ1単位増えると,予測とはそれぞれ

だけ増える。

この特徴はすべてのインスタンス(入力)について共通しているので,回帰係数は特徴量とモデルの予測値の(インスタンスごとではない)平均的な関係を解釈していると言える。

特徴量の予測値とインスタンスごとの関係

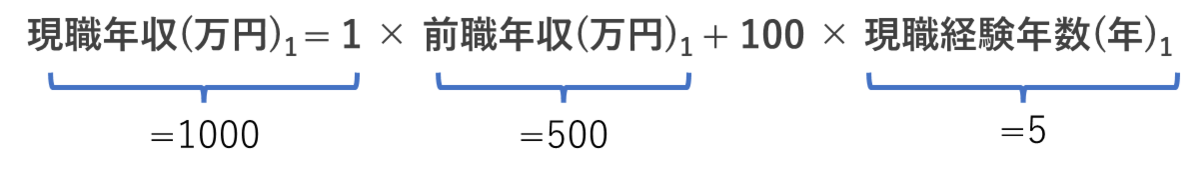

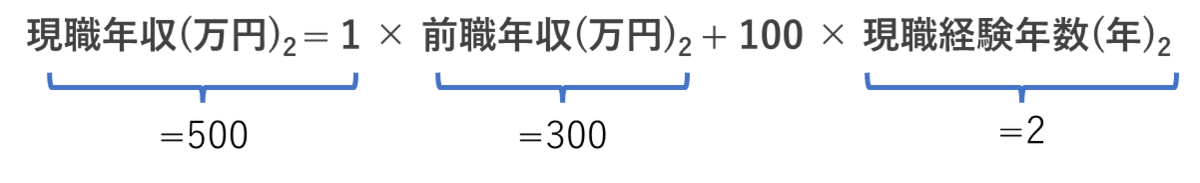

以下のような,線形回帰モデルを考える。

この式にはという項が入っており,

に関しては非線形になる。この式を微分すると,

となる。この式より,が1単位増加したときに予測値に与える影響は,

の水準にしたがって異なる。具体的には,

とすると,

となり,インスタンスごとに特徴量が予測値に与える影響が異なる。

すなわち線形回帰モデルは,特徴量と予測値のインスタンスごとの関係を解釈できるといえる。

特徴量の重要度

次のような線形回帰モデルを考える。

たとえば,とすると,特徴量

がそれぞれ1単位変化したときに予測値が最も大きく動くのは

である。一方で

にどんな値を入れても予測値には影響がない。

このように線形回帰モデルは,回帰係数の絶対値を見ることで,モデルの予測にどの特徴量が強く影響するかが分かる。

ただし回帰係数を比較するうえで気を付けるべきことは,特徴量の値の大きさの範囲を揃えておくことである。大きさの範囲を揃えるための手法として,特徴量を標準化(standardization)することが挙げられる。