はじめに

持橋大地・鈴木大慈 監訳「確率的機械学習 入門編I」は,世界的に評価の高いK.P.Murphy著 "Probabilistic Machine Learning (Book1)" の和訳であり,確率モデルに基づく機械学習,深層学習といった基礎が丁寧に整理されている。私は統計検定1級として数理統計の基礎は学んできたが,機械学習・深層学習は実務に応じて場当たり的に学んできた。実務での応用に向けて,機械学習・深層学習の基礎を体系的に学び,チームの技術力を底上げしたいと考えている。また読書メモに自身の理解をまとめることで,製造業に携わる若いエンジニアにとっても有益な知識を還元できればと考えている。

※なおボリュームが多い本なので,知っているところは端折りながら読み進めたい。

4.6 ベイズ統計学

本節では,推定における不確実性を扱うことができるベイズ統計学について説明している。

「推定の不確実性」を考慮する応用シーンとして,能動学習や過剰適合の回避などが挙げられる。

ベイズ統計学における予測

パラメータの事後分布を計算した後に,入力が与えられた下での事後予測分布は,

●ブログ筆者註 :

上記の事後予測分布は,

から

を1つ生成する。

を入力として,

を構成する。

について足し合わせる(積分する)。

という手順で得ていると解釈できる。

このような足し合わせをベイズモデル平均と呼ぶ。

4.6.1 共役事前分布

本節では,共役事前分布(conjugate prior)について説明している。

共役事前分布とは,事前分布と事後分布事前分布

が同じ分布族

に属するような事前分布のことである。

4.6.2 ベータ・二項モデル

本節では,共役事前分布の例として,ベータ・二項モデルを紹介している。

ベータ・二項モデルでは,

- 尤度 : ベルヌーイ分布

- 事前分布 : ベータ分布

としている(尤度は二項分布でもよい)。

そのため事後分布は,

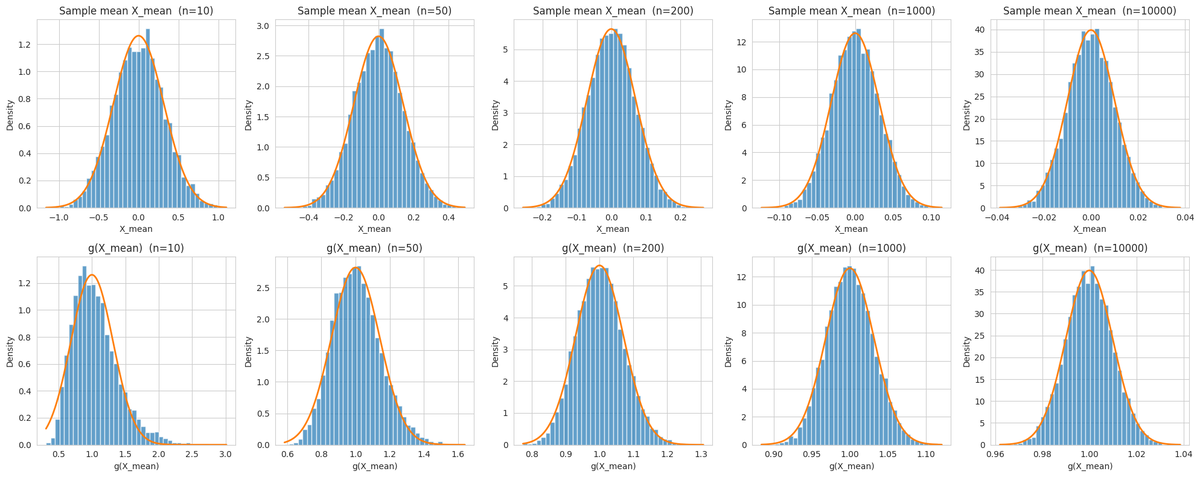

下図に,事前分布がベータ分布の場合(左)と一様分布(右)の場合を示す。事前分布がベータ分布の場合は,尤度と事前分布のバランスを取るような事後分布が形成される。一方で事前分布が一様分布の場合は,尤度と事後分布が一致する。

事後平均

事後分布のモードは単一の点であるため,事後分布の特徴が十分に捉えきれていないことがある。モードよりも頑健な推定として,事後平均が挙げられる。

まとめと感想

今回は,「4 統計学」のベイズ統計学における,ベータ・二項モデルについてまとめた。

ベータ分布は共役事前分布の代表選手

本書では,ベータ・二項モデルを題材に,事後分布のモード(MAP推定),事後平均,事後分散,事後予測分布など,事後分布から導出される様々な統計量・分布を紹介していた。

事後分布は一般に計算しづらいと言われているが,ベータ・二項モデルは事後分布が解析的に求まるので,様々な性質を理解するうえで有益だと感じた。

本記事を最後まで読んでくださり,どうもありがとうございました。

参考サイト

- 確率的機械学習:入門編 I |朝倉書店

- 『確率的機械学習:入門編』サポートサイト

- 原著関連

- Probabilistic Machine Learning: An Introduction : 原著のサポートページ

- pyprobml/notebooks.md at auto_notebooks_md · probml/pyprobml · GitHub : 原著の図作成用Notebooks一覧